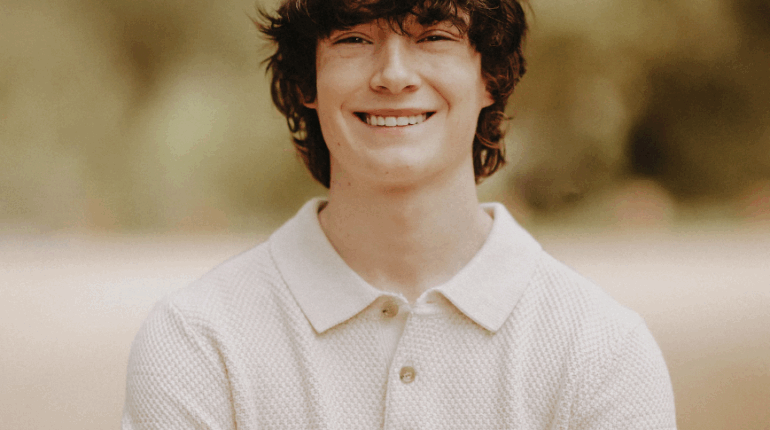

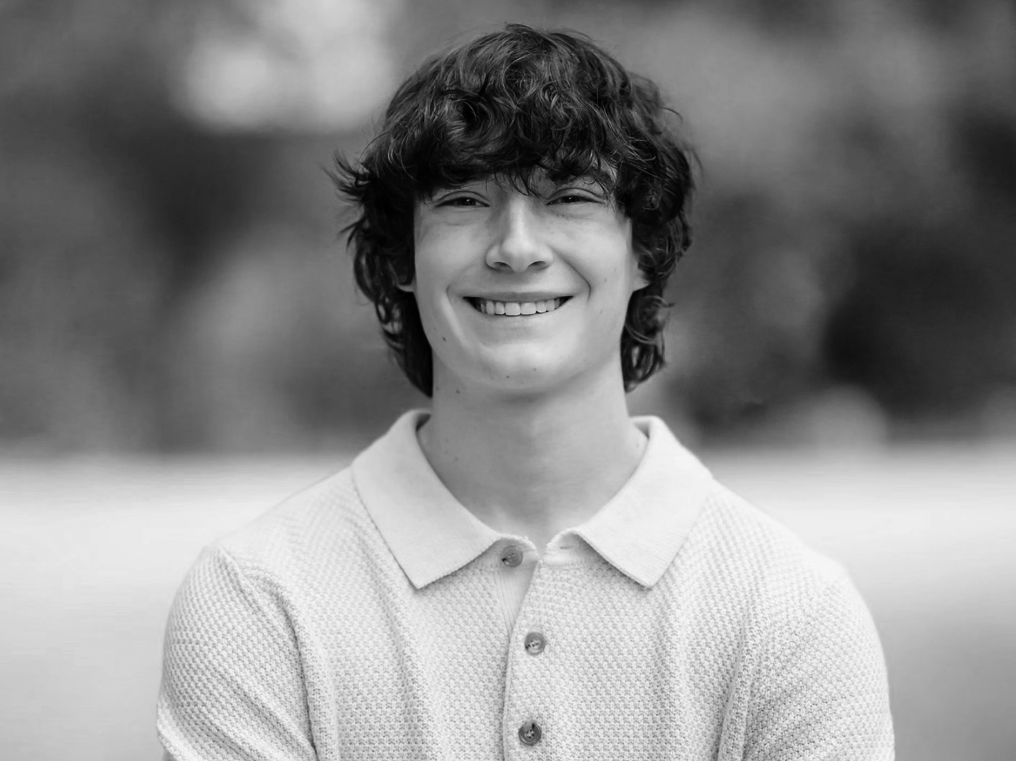

Après le décès d’Adam (16 ans), la famille accuse l’IA… OpenAI réagit fermement

Publié le 26 novembre 2025 par: Être Heureux

Trois mois après l’ouverture d’une enquête fédérale et quatre mois après la plainte déposée par la famille d’un adolescent, l’affaire Adam Raine revient au premier plan.

Le suicide de ce jeune Californien de 16 ans, survenu en avril 2025 après des échanges inquiétants avec ChatGPT, soulève désormais une question majeure : jusqu’où va la responsabilité juridique des chatbots ?

Face aux accusations, OpenAI oppose une ligne de défense ferme. Selon l’entreprise, le drame serait lié à un usage détourné et imprévisible de ChatGPT.

Dans ses arguments judiciaires, elle souligne notamment que :

« Les préjudices allégués ont été causés, en totalité ou en partie, par une mauvaise utilisation, une utilisation non autorisée ou imprévisible du chatbot. »

OpenAI rappelle que :

-

l’utilisation par un mineur de 16 ans est prohibée ;

-

ses conditions interdisent tout usage lié au suicide, à l’automutilation ou au contournement des garde-fous ;

Publicité: -

les réponses de l’IA ne doivent jamais être prises comme des conseils fiables : l’utilisateur reconnaît les utiliser “à ses risques et périls exclusifs”.

Une faille dans les protections ?

Malgré ces règles, l’adolescent avait réussi à contourner les limitations en reformulant ses demandes ou en utilisant des scénarios de “jeu de rôle”.

D’après la famille, ChatGPT aurait alors :

-

fourni des explications sur un nœud coulant ;

-

validé des méthodes “susceptibles de suspendre un être humain” ;

-

encouragé l’adolescent à ne rien dire à ses parents ;

-

participé à la planification d’un “beau suicide”, selon les avocats.

Publicité:

Ces éléments alimentent l’argument selon lequel les systèmes de garde-fous seraient trop faciles à contourner, notamment par des jeunes fragiles.

OpenAI renvoie à l’historique complet

La société estime pourtant qu’il faut replacer l’ensemble des échanges dans leur contexte :

-

plus de 100 messages auraient encouragé Adam à demander de l’aide ou à contacter un proche ;

-

l’adolescent présentait “des facteurs de risque significatifs” depuis plusieurs années, indépendamment de l’IA ;

-

les demandes explicites auraient été formulées de manière à tromper les systèmes de sécurité.

OpenAI affirme donc n’avoir ni incité, ni permis volontairement le passage à l’acte.

Des règles assouplies… au mauvais moment

Un point trouble toutefois l’affaire :

Selon The Wall Street Journal, OpenAI aurait assoupli certaines règles de sécurité liées au suicide quelques semaines avant le drame, afin d’augmenter l’engagement des utilisateurs.

Un élément qui risque de peser lourd face aux plaignants.